Imagine conectar diversos dispositivos, através da internet, que podem trocar informações entre si? Essa é a ideia por trás da Internet das Coisas (IoT). Aplicado à indústria, a conexão entre esses diversos dispositivos é a IoT na indústria 4.0.

Indústria 4.0 é conhecida como a Quarta Revolução Industrial, caracterizada pela introdução da tecnologia da informação na indústria. Essa é a nova tendência que está sendo adotada pelas grandes corporações para sair na frente em seu mercado.

Para entender essa ideia de IoT na indústria 4.0, vamos fazer uma analogia com o funcionamento do cérebro humano. Em 1926, Nikola Tesla, inventor nos campos de engenharia mecânica e eletrotécnica, disse:

“Quando a tecnologia sem fio for perfeitamente aplicável, a Terra inteira será convertida em um imenso cérebro, o que de fato é, com todas as coisas sendo partículas de um todo real e rítmico”

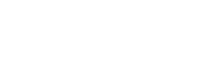

Sendo assim, essa analogia ao nosso cérebro permite compreender melhor a ideia de IoT como uma rede conectada. Essa rede por si só possui imensas quantidades de conexões entre as células, compondo a rede do nosso sistema nervoso.

Portanto, assim como células diferentes possuem finalidades diferentes, os produtos conectados possuem diferentes funções e aplicabilidades, porém estão unidos sob a mesma rede.

As conexões geradas pela IoT

Essa conexão que a IoT na indústria 4.0 fornece, gera oportunidades inéditas, criando um grande círculo de valor agregado aos produtos e serviços que dela se utilizam. Entenda melhor como isso pode funcionar na prática, a partir da sequência de fatores a seguir:

- A chuva influencia a produção de matéria-prima

- O valor do produto final sofre alterações no mercado mundial

- A quantidade de produtos derivados estocados impacta a economia nacional

- Ocorre uma repentina elevação da demanda, cujo fornecimento de insumos não consegue suprir.

- Em vez da produção ser intensificada, será interrompida para uma parada programada de manutenção.

Sendo assim, imagine um monitoramento integrado de todos esses acontecimentos, gerando dados que se comunicam em tempo real por meio do que pode-se considerar uma grande base de dados unificada.

A partir desse banco de dados, seriam tomadas decisões automáticas através da comunicação online entre os dispositivos interconectados responsáveis por monitorar esses eventos.

Com base nas decisões tomadas por meio da visão global de todos esses fatores, o processo produtivo se torna mais eficiente, reduzindo os impactos negativos e maximizando a cadeia de valor de determinado setor industrial.

Então, essa integração não só interna como externa à indústria, é a base da IoT na indústria 4.0. A nível mundial, a Accenture realizou um estudo para ter uma projeção do impacto na economia com a internet industrial das coisas (IIoT) nos próximos anos.

Diante disso, as previsões mais otimistas apresentam que o valor gerado pelo investimento em IIoT chegará a US $ 15 trilhões do PIB global até 2030. Esse estudo pode ser consultado através deste link.

Depois desse panorama mundial, vamos aprofundar mais nos assuntos. Aqui nesse artigo sobre IoT na indústria 4.0, você pode entender melhor sobre:

- O que é a indústria 4.0

- O que é IoT

- Como a IoT na indústria 4.0 pode revolucionar a indústria

- Benefícios da IoT na indústria 4.0

Afinal, o que é a indústria 4.0?

O surgimento da indústria 4.0 veio por meio dos alemães que queriam elevar sua competitividade com a manufatura asiática. Por isso, definiram uma estratégia de governo para aumentar a produtividade da indústria através da inovação.

Segundo a chanceler da Alemanha, Angela Merkel:

“A indústria 4.0 é a transformação completa de toda a esfera da produção industrial através da fusão da tecnologia digital e da internet com a indústria convencional.”

Apesar da disseminação do conceito mundialmente, ele ainda não é uma realidade. Essa é a primeira vez que uma revolução industrial é anunciada antes de acontecer. Todos os acontecimentos estão sendo previstos como tendências.

Dessa forma, a Quarta Revolução Industrial está sendo motivada por três grandes mudanças no mundo industrial produtivo. São elas:

- Avanço exponencial da capacidade dos computadores;

- Imensa quantidade de informação digitalizada;

- Novas estratégias de inovação (pessoas, pesquisa e tecnologia).

Essas mudanças permitem que tudo dentro e ao redor de uma planta operacional (fornecedores, distribuidores, unidades fabris, e até o produto) sejam conectados digitalmente, proporcionando uma cadeia de valor altamente integrada.

Em meio a tudo isso, o que significa a Internet das Coisas (IoT)?

A IoT na indústria 4.0 é basicamente a responsável pela integração de todos os dispositivos dentro e externo à planta. A IoT é o conceito que representa a conexão.

“A Internet das Coisas é uma rede de objetos físicos, sistemas, plataformas e aplicativos com tecnologia embarcada para comunicar, sentir ou interagir com ambientes internos e externos.”

Quando se diz que a internet está na indústria, no chão de fábrica, devemos relacionar isso a um ambiente onde todos os equipamentos e máquinas estão conectadas em redes e disponibilizando informações de forma única.

Desse modo, especificamente quando falamos do universo da Internet das Coisas na indústria, nos referimos a Industrial Internet of Things (IIoT). Conheça o nosso artigo sobre IIoT para se aprofundar no assunto e entender como esse conceito está funcionando atualmente.

Para deixar mais claro, vamos ressaltar a diferença entre IoT e IIoT. IoT é o conceito mais abrangente que surge como a ideia de conectar qualquer dispositivo que gere informações e possa se conectar a um serviço de cloud em qualquer segmento.

Em contrapartida, a IIoT é a conexão de diferentes dispositivos relacionados à cadeia produtiva, conectando essas informações via cloud. Por exemplo, permitindo o processo produtivo conectar-se diretamente a um fornecedor de produto em tempo real na linha de produção.

Como a IoT na indústria 4.0 está revolucionando a indústria?

Agora que já entendemos os conceitos, vamos apresentar exemplos do que já está sendo feito atualmente. A IoT na indústria 4.0 já está presente em diferentes segmentos e atuando de diferentes maneiras.

1) Otimizando a manutenção na energia eólica

A Schaeffler e a IBM vão utilizar turbinas eólicas para explorar como Machine Learning pode revelar insights valiosos sobre a performance de equipamentos em diferentes condições de operação.

Assim, sensores nos equipamentos informam as condições dos componentes da turbina em tempo real. Dessa forma, através da previsão do vento pela IBM, os operadores de turbina estão aptos para planejar com antecedência e repor peças durante períodos menos ventosos.

2) Aumentando a eficiência operacional de plantas industriais com gerenciamento de alarmes e eventos

É muito comum indústrias possuírem milhares de eventos disparados pelo sistema de automação da planta. Sejam informações de alarmes, intervenções, mudança de estados, tudo fica registrado como eventos.

A quantidade é tão grande que se torna impossível realizar a análise desses dados sem ser por softwares especializados

Assim, visando amenizar esse problema, existe a prática de gerenciamento de alarmes e eventos. Um software de gerenciamento conecta-se ao sistema de controle e consegue extrair todas as informações dos milhares de dados gerados diariamente.

Essa grande quantidade de dados brutos são minerados e transformados em insights valiosos sobre as condições da planta industrial. Esse processo é denominado business intelligence.

Ainda assim, existe uma lacuna muito grande de sistemas que de fato conseguem minerar esses dados em tempo real gerando informações relevantes que facilitem o processo de tomada de decisão seja de maneira manual ou automática.

A maioria das indústrias sequer realiza a análise desses dados de maneira proativa, servindo apenas para registros para caso de necessidade de avaliação como, em análise de incidentes.

Por fim, o gerenciamento de alarmes e eventos facilita o trabalho do operador que consegue controlar a planta com maior precisão, aumentando a produtividade e diminuindo as perdas.

3) Veículos Conectados

A IoT na indústria 4.0 também permite que a Schaeffler amplie a funcionalidade e a vida útil de componentes da indústria automotiva. Eles conseguiram encontrar um modelo de negócio híbrido a partir desta ideia.

Desse modo, análises e sistemas sensoriais em tempo real podem transformar dados brutos em insights valiosos que podem ser utilizados pelos fabricantes para aumentar a confiabilidade dos carros e oferecer um novo serviço de valor agregado aos clientes.

Dessa forma, eles conseguem ampliar a qualidade para além da porta da fábrica. Pois, fornece em tempo real aos clientes as condições dos seus respectivos carros.

Quais os benefícios da IoT na indústria 4.0?

Compreendido como funciona na prática, quais os benefícios que tudo isso oferece? A utilização de IoT e IIoT, trazem benefícios para as plantas industriais nos seguintes aspectos:

1- Eficiência operacional e maximização dos lucros

A eficiência operacional é o mais falado atualmente, e os primeiros adeptos estão focados nesses benefícios.

Ao introduzir automação, conectividade e técnicas de produção mais flexíveis, por exemplo, os fabricantes podem aumentar sua produtividade em até 30%. Esse dado também foi disponibilizado pelo estudo realizado pela Accenture.

Além disso, a escalabilidade, economia de tempo e de custos, auxilia na maximização dos lucros de organizações industriais.

Os aspectos que aumentam a eficiência operacional da planta são:

- Redução de paradas na produção;

- Melhoria do uso do ativo;

- Redução no custo do ciclo do ativo;

- Melhoria da produção;

2- Novos serviços e modelos de negócios

A IoT na indústria 4.0 permite que sejam criados novas fontes de receitas pela criação de novos serviços conectados. Os modelos de negócio híbridos, permitem que sejam aproveitados tantos os produtos quanto serviços digitais.

Sob o mesmo ponto de vista, o modelo de negócio híbrido são negócios que oferecem tanto produtos quanto um serviço relacionado à esse produto.

No exemplo anterior dos veículos conectados, a Schaeffler aproveitou os dados brutos obtidos para fornecer o serviço de condição dos carros em tempo real como fonte para manutenções preventivas.

A utilização de serviços digitais ainda melhora o relacionamento com o cliente. Pois, a entrega do produto possibilita diferentes pontos de contatos que geram informações valiosas para o cliente. É criada uma relação de confiança e lealdade.

3- Maior conhecimento para tomadas de decisões

A análise dos dados industriais permite que os executivos tenham maior quantidade de informação. Isso facilita para tomarem melhores decisões em virtude de ter uma visão mais precisa do desempenho da indústria.

Para completar, a rede da IIoT de dispositivos inteligentes permite que as organizações industriais conectem todas as suas pessoas, dados e processos do chão de fábrica até os executivos. Auxiliando ainda mais na produtividade dos líderes e nas tomadas de decisão.

É importante ressaltar que mais do que facilitar as tomadas de decisão, a indústria 4.0 quer ir além. Ela visa promover que boa parte dessas decisões sejam tomadas de maneira automática por técnicas inteligentes.

Conclusão

A melhor maneira de inovar em um setor industrial é quando você consegue identificar uma tendência de comportamento e se antecipa para aplicar uma nova ideia na sua indústria.

O mercado já está nos mostrando que o mundo caminha para a Quarta Revolução Industrial. Isso representa a introdução da tecnologia da informação nas indústrias.

Portanto, para as empresas que buscam sair na frente dentro do seu mercado e inovar, apostar na internet das coisas e IoT na indústria 4.0 pode ser um ótimo caminho.

Por fim, existe ainda um potencial escondido para um alto crescimento das indústrias, esse potencial é a utilização dos dados. Um bom uso desses dados permite aumentar a eficiência operacional, tomar melhores decisões e até criar novos modelos de negócio.

Computação em Nuvem está muito presente hoje no nosso dia a dia: quando você acessa o e-mail do seu celular ou arquivos no seu smartphone; quando você está acessando a sua TV na Netflix para assistir um vídeo; a partir do momento que você está com sua conta do Nubank, todos esses dados e arquivos estão armazenados em nuvem.

Computação em Nuvem está muito presente hoje no nosso dia a dia: quando você acessa o e-mail do seu celular ou arquivos no seu smartphone; quando você está acessando a sua TV na Netflix para assistir um vídeo; a partir do momento que você está com sua conta do Nubank, todos esses dados e arquivos estão armazenados em nuvem.

Muita! Existe muita segurança em ambiente de nuvem. Existe replicação, existe alta disponibilidade. A falha de segurança é dos administradores que usam esse ambiente.

Muita! Existe muita segurança em ambiente de nuvem. Existe replicação, existe alta disponibilidade. A falha de segurança é dos administradores que usam esse ambiente. Aí é onde entra a importância do papel do

Aí é onde entra a importância do papel do

Guilherme Falcão / Getty Images

Guilherme Falcão / Getty Images

/i.s3.glbimg.com/v1/AUTH_08fbf48bc0524877943fe86e43087e7a/internal_photos/bs/2020/Z/1/mvDymmQjCp2yrPyVS3uA/brl-9944.jpg)